A internet é usada por centenas de milhões de pessoas todo dia, mas o tráfego provocado por robôs é ainda maior. É isso que conclui o relatório anual de tráfego da empresa Imperva Incapsula. A empresa analisou o tráfego em mais de 16,7 bilhões de visitas a mais de 100 mil sites escolhidos aleatoriamente num período de 90 dias para chegar a essa conclusão.

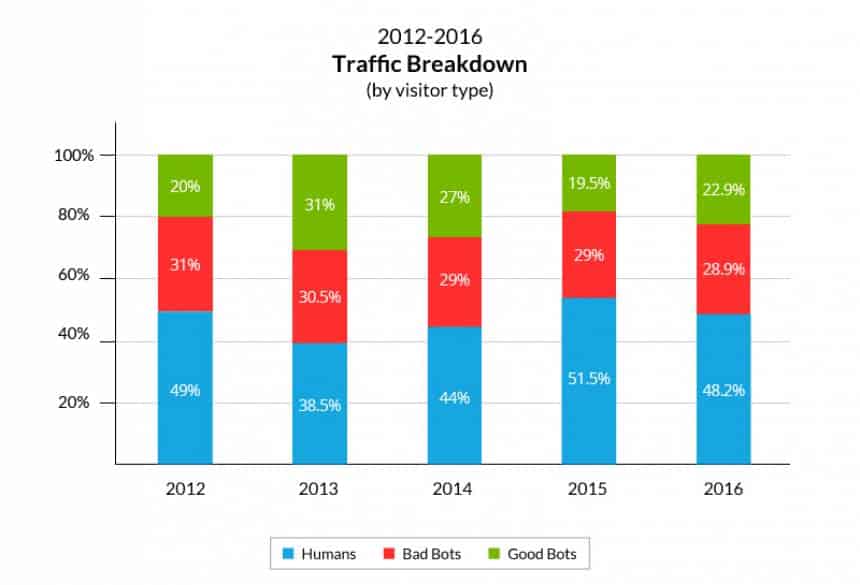

Segundo os dados da Incapsula, apenas 48,2% do tráfego da rede é causado por nós. Esse valor, aliás, já foi menor: em 2013, humanos respondiam por apenas 38,5% do tráfego. Após anos em ascenção, essa porcentagem voltou a cair em 2016. Em 2015, os humanos causaram 51,5% do tráfego da rede – a primeira vez desde o início das medições em que nós respondemos por mais da metade.

Os outros 51,2% do tráfego dem 2016 foi feito por robôs, ou bots. Mais especificamente, 22,9% dele foi feito por robôs “bons”, como ferramentas de busca ou de feed de notícia, e 28,9% por robôs “maus”, como ladrões de conteúdo e disseminadores de spam. O gráfico abaixo dá mais detalhes sobre a evolução desses números ao longo do tempo:

Os bons, os maus e os humanos

De acordo com o relatório, o aumento do tráfego causado por bots em 2016 foi causado principalmente por um aumento na partiipação dos bots “bons”. Robôs “bons” são, por exemplo, os “spiders” e os “feed fetchers”. Os “spiders” são robôs usados por sites de busca: eles ficam viajando pela internet visitando e indexando novos sites que encontram pelo caminho.

Os “feed fetchers”, por sua vez, fazem uma tarefa semelhante para buscar conteúdo para os feeds de notícia de usuários de redes sociais. Apenas os “spiders” do Google e os “feed fetchers”do Facebook geram mais de 8% do tráfego da internet inteira.

Por outro lado, há também os “robôs maus” que, como o nome indicam, são usados para roubo de dados ou cibercrime. Alguns exemplos de “robôs maus” são so que se passam por usuários humanos para promover ataques DDoS, os que falsificam links e comentários e sites e fóruns para espalhar spam, e ferramentas usadas por hackes para buscar vulnerabilidades em sites.

Por que isso importa

Pode até ser curioso que os robôs causem tanto tráfego, mas isso também é um problema. De acordo com o Axios, os robôs custam cerca de US$ 7 bilhões por ano às empresas que investem em publicidade online. Isso porque essas empresas pagam para que suas propagandas sejam vistas por humanos, e não por robôs, e é necessário investir bastante dinheiro para que isso se concretize.

Como o número de “robôs maus” na internet é muito grande, porém, a probabilidade de que eles cheguem a um site específico também é. Ainda segundo a Imperva, 94,2% dos mais de 100 mil sites avaliados no estudo foi visitado por um bot “do mal” ao longo dos 90 dias do levantamento. Embora trate-se geralmente de apenas uma aferição em busca de vulnerabilidades (que é muito menos perigosa que um ataque direcionado), essas visitas podem acabar comprometendo sites menos protegidos.

Fonte: Olhar Digital